ÉTHIQUE ET ENJEUX DE L’IA GÉNÉRATIVE

L’essor de l’intelligence artificielle générative depuis 2022 transforme fortement les milieux éducatifs, sociaux et professionnels. Les cadres internationaux insistent sur des balises éthiques claires et une approche centrée sur l’humain, la transparence et l’inclusion (UNESCO, 2025). Les ressources de terminologie et d’éthique rappellent que les modèles apprennent à partir de données humaines imparfaites et biaisées, d’où la nécessité d’une réflexion critique soutenue (Abécédaire de l’IA, 2024). En FLS, ces enjeux sont amplifiés par les dimensions linguistique, culturelle et identitaire de l’apprentissage d’une langue seconde (Moorhouse & Wong, 2025; Michelot & Collin, 2024).

2.1. L’éthique de l’IA

L’Abécédaire de l’IA (2024), développé par l’Axe Éducation et Capacitation de l’Obvia, propose plusieurs concepts à retenir sous la catégorie de « éthique de l’IA ». Je fournis ci-dessous quelques-uns, accompagnés d’une définition provenant de cet outil ainsi que de l’exemple illustré, afin de mieux comprendre les préoccupations éthiques liées à l’utilisation de l’IA.

- Biais : « Plusieurs données utilisées par les systèmes d’IA peuvent être biaisées notamment parce qu’elles reflètent des biais de notre société. »

Exemple :

- Confabulation : « … les IA donnent parfois des résultats inexacts, incohérents ou même faux en les présentant comme vrais… parce qu’on ne demande à ces IA Génératives que de générer de façon probabiliste ce qui est le plus plausible selon un contexte donné. »

Exemple :

La confabulation menace la culture informationnelle si les apprenant.e.s délèguent la vérification.

- Désinformation : « … une information fausse ou inexacte dont la diffusion vise à nuire ou manipuler l’opinion publique. »

Exemple :

- Fracture numérique : « … l’écart plus ou moins important qui se crée entre les personnes ayant accès aux technologies et ceux qui en sont exclus. […] Avec l’arrivée de l’IA, plusieurs anticipent que cette fracture s’aggrave notamment en avantageant les personnes ayant une bonne littératie de l’IA dans le marché du travail […] . »

Exemple :

- Humain dans la boucle : « L’IA est une technologie programmée pour prendre des décisions… qui peuvent avoir des conséquences directes sur les personnes concernées. Or, ces décisions peuvent comporter des erreurs, des biais ou de la désinformation. »

Exemple :

- Hypertrucage (angl. deepfake) : « … l’utilisation de l’IA pour créer des images, vidéos ou enregistrements audios de toutes pièces. […] des personnes peuvent avoir participé à des évènements qui n’ont jamais eu lieu ou dit des paroles qui n’ont jamais été prononcées. »

Exemple :

- Risques : « […] Il faut identifier et caractériser les risques individuels, politiques et communicationnels des IA. Une des difficultés est que certaines productions des IA ne peuvent pas être clairement identifiées comme de source humaine ou de source IA par des humains (test de Turing). Cela pose des questions complexes en termes de justice, de discrimination, de droits d’auteurs et de propriété des données, des systèmes IA et des produits de l’IA. »

Exemple :

- Sobriété numérique : « … l’idée de réfléchir à la façon de réduire l’utilisation des technologies afin de protéger l’environnement, notamment parce que l’utilisation des appareils numériques (ordinateurs, téléphones, etc.) consomme beaucoup d’énergie et de ressources. »

Exemple :

- Transparence : « … un système d’IA … doit notamment partager comment il fonctionne, comment il utiliser nos données, et comment il prend en compte les limites et les incertitudes dans ses décisions. »

Exemple :

- Vie privée : « … ‘l’ensemble des phénomènes qui sont personnels, tant sur le plan physique que mental’ (Office de la langue française, 2024). Dans le domaine de l’IA, la vie privée concerne la protection et le contrôle des données personnelles lors de la conception et du déploiement des technologies d’IA. »

Exemple :

Les IAg apprennent à partir de corpus massifs susceptibles de contenir des stéréotypes et des hiérarchies linguistiques. Elles peuvent reproduire et amplifier des inégalités sociales (UNESCO, 2025). En FLS, la standardisation du français international au détriment des variétés régionales est un enjeu majeur, qui affecte la représentation de la diversité, l’évaluation et la perception du ‘bon français’ (Abécédaire de l’IA, 2024; Michelot & Collin, 2024). Le développement d’une compétence numérique critique est nécessaire pour équilibrer ces effets.

Tableau 2. Exemples de types de biais et stratégies d’atténuation (UNESCO, 2025; Abécédaire de l’IA, 2024; Michelot & Collin, 2024)

| Type de biais | Exemple en FLS | Effet potentiel | Atténuation (classe) |

| Linguistique (registre) | Préférence pour un français standardisé | Uniformisation des productions; perte de voix | Comparer variétés FR‑CA/FR‑EU; corpus authentiques; activités critiques |

| Culturel | Références dominantes occidentales | Invisibilisation de cultures minorisées | Textes pluriels; validation par pairs; contextualisation |

| Données | Corpus non représentatifs | Biais systématiques dans sorties IA | Diversifier sources; triangulation; discussion guidée |

| Accès | Modèles payants vs gratuits | Iniquité de performance | Alternatives institutionnelles; transparence; accommodations |

Il nous incombe de vérifier la fiabilité des sources, d’encourager les étudiant.e.s à adopter une démarche d’analyse critique pour tout contenu qu’ils saisissent dans un système et de maintenir une ouverture à des discussion guidées sur les limites de l’IA (UNESCO, 2025).

2.2. Maintenir l’intégrité académique : Cadres et modèles pratiques

Bien que plusieurs personnes aient posé – et poseront – des questions sur les détecteurs d’IA, je préfère laisser cette discussion à celles et ceux qui sont davantage spécialisés dans le domaine de l’intégrité académique et des règles institutionnelles établies par l’université. De nombreux défis éthiques émergent dès que l’on envisage leur utilisation, ce qui mérite une réflexion approfondie plutôt qu’une adoption immédiate.

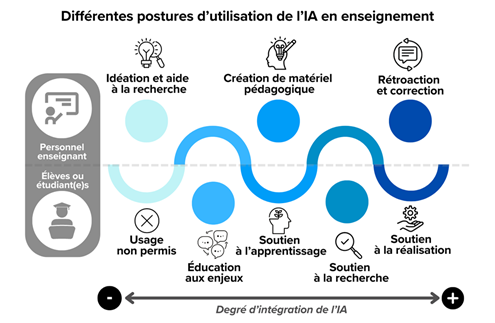

Puisque les détecteurs d’IA sont peu fiables et biaisés — particulièrement envers les scripteurs non natifs — la conception d’évaluations doit privilégier l’authenticité, l’agentivité et la transparence (Furze, 2024). Les postures des enseignant.e.s et des apprenant.e.s varient de l’usage non permis à la collaboration créative. Un cadre clair, comme celui proposé par Duguay (2024), aide à définir les attentes et à soutenir une utilisation responsable :

Je propose deux modèles qui nous permettent d’être plus flexibles et d’individualiser nos pratiques pédagogiques :

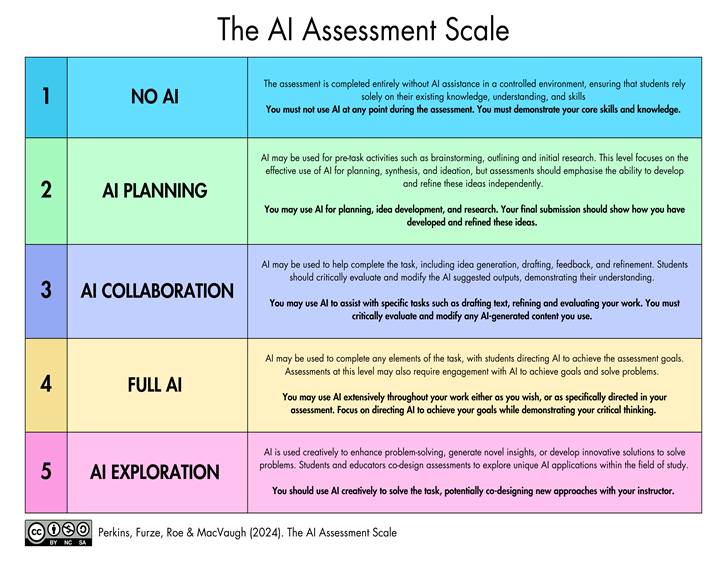

L’échelle AIAS (angl. The AI Assessment Scale) de Leon Furze et ses collègues clarifie les niveaux d’autorisation, de l’usage non permis à l’usage étendu, avec des tâches adaptées.

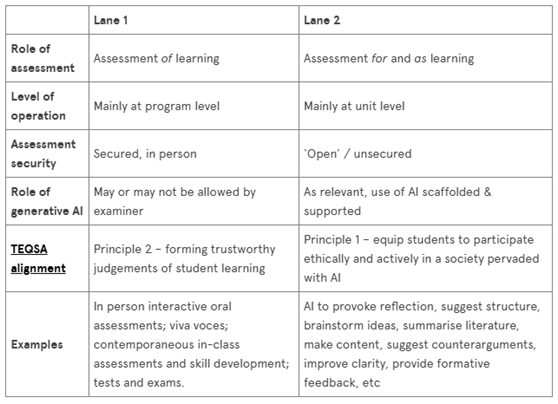

L’intégration de l’IA en classe peut suivre un continuum allant de l’usage non permis à l’usage étendu, tout en respectant l’approche d’évaluation à deux voies (angl. Two-Lane Approach to Assessment) de Danny Liu et ses collègues :

- Voie 1 (sécurisée) : activités en présentiel, sans IA, pour garantir l’authenticité et la sécurité des évaluations.

- Voie 2 (ouverte et encadrée) : activités où l’IA est utilisée de manière critique et transparente pour soutenir l’apprentissage.

Voici quelques exemples pour FLS qui combine les deux modèles (adapté de Copilot 2025):

#1 Usage non permis / Sans IA (Voie 1)

- Modalité : Évaluations sécurisées, sans IA.

- Exemples : Débats, exposés et présentations en classe, dictées, rédaction manuelle avec brouillons datés.

- Risques : Substitution par IA hors classe, contraintes logistiques, limitation des compétences évaluées.

#2 Planification avec IA (Voie 2)

- Modalité : IA utilisée pour la planification ou la génération d’idées.

- Exemples : Remue-méninges assisté par IA pour organiser un plan de rédaction ou un projet multimodal.

- Risques : Uniformisation des idées, perte de diversité et de créativité.

#3 Collaboration avec IA (Voie 1 ET Voie 2)

- Modalité : Collaboration avec IA pour améliorer le travail, mais sous supervision.

- Exemples : Processus d’écriture avec feedback IA, révision linguistique suivie d’une réflexion métacognitive.

- Risques : Dépendance à l’IA (manque d’équilibre), perte d’agentivité, déchargement cognitif.

#4 IA complètement permise (Voie 2)

- Modalité : IA utilisée pour réaliser des segments complets ou des tâches multimodales.

- Exemples : Génération d’illustrations, audio ou vidéo pour un projet créatif.

- Risques : Dépendance à l’IA (aucun équilibre), iniquité d’accès aux outils, manque de transparence, perte d’agentivité, déchargement cognitif.

#5 Exploration avec IA (Voie 2)

- Modalité : Usage étendu et créatif de l’IA pour cocréer des projets.

- Exemples : Création d’une capsule vidéo ou d’un portfolio numérique avec prompts IA, citation des sources et licences ouvertes.

- Risques : Traçabilité, droits d’auteur.

L’intégration des systèmes d’IA en éducation ne se limite pas à des considérations techniques : elle soulève des défis éthiques, sociaux et pédagogiques qui exigent une approche réfléchie. Les deux modèles proposés peuvent guider cette intégration et permettent de répondre aux principaux enjeux de l’IAg :

- La protection des données impose des pratiques sûres (consentement explicite, anonymisation, outils institutionnels, citation des générateurs, respect des cadres juridiques). Les communautés autochtones rappellent l’importance du contrôle communautaire (Abécédaire, 2024; UNESCO, 2025).

- Un usage non encadré peut réduire la motivation en donnant l’impression que « la machine fait à leur place ». À l’inverse, une intégration critique orientée vers la créativité (analyse, réécriture, projets multimodaux) renforce l’engagement (Michelot & Collin, 2024; Moorhouse & Wong, 2025).

- Les systèmes d’IA ont une empreinte énergétique importante; la sobriété numérique et la diversification des tâches limitent cet impact. L’IA peut accentuer les inégalités d’accès; proposer des alternatives non technologiques constitue une pratique responsable (Abécédaire, 2024; UNESCO, 2025).

- L’usage des détecteurs d’IA soulève des défis éthiques qui méritent une réflexion extrêmement approfondie plutôt qu’une adoption immédiate. La transparence, la traçabilité et la formation à l’analyse critique sont essentielles.

Pour conclure, l’éthique de l’IAg exige une posture réflexive et nuancée. En FLS, une intégration encadrée et motivée par des objectifs pédagogiques clairs – en s’appuyant sur l’échelle AIAS et l’approche d’évaluation à deux voies – permet de préserver la créativité et l’agentivité des apprenant.e.s tout en tirant parti des apports des IA.